这是一个非常好的问题,也是很多想进入大数据领域的人都会问的。

Hadoop自学有难度,但并非不可能,它的难度不在于“学不会”,而在于“体系庞大、概念抽象、实践门槛高”。

下面我将从几个方面详细拆解这个问题,帮助你判断自己是否适合自学,以及如何高效地自学。

为什么说Hadoop自学有难度?

-

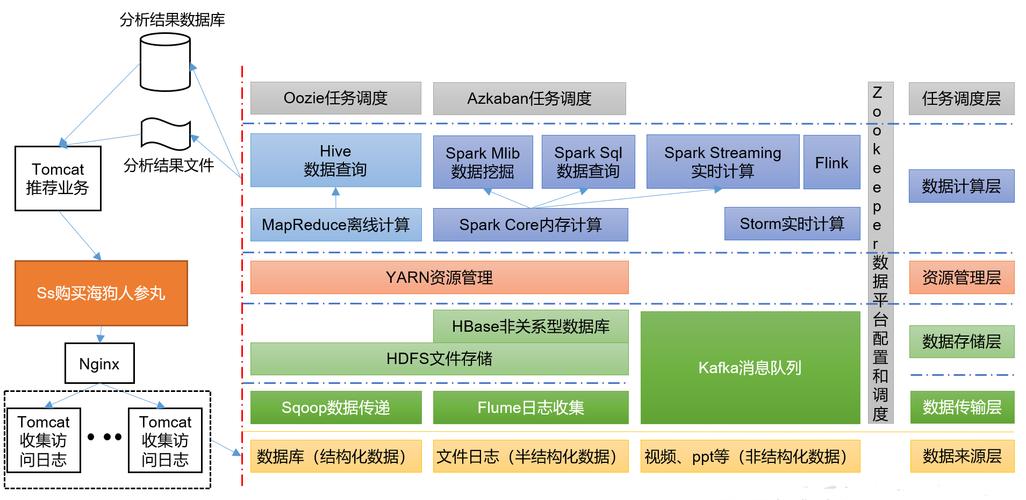

知识体系庞大且环环相扣 Hadoop不是一个单一的技术,而是一个由多个组件构成的生态系统,你不可能只学HDFS就完事了,核心组件及其依赖关系如下:

- 基础理论: HDFS (分布式文件系统)、MapReduce (分布式计算模型),这是Hadoop的基石,理解它们的原理至关重要。

- 资源管理: YARN (资源调度器),MapReduce的计算任务需要YARN来分配CPU和内存资源。

- 数据仓库: Hive (构建在Hadoop之上的数据仓库工具),它让你能用类似SQL的语言查询Hadoop中的数据,这是实际工作中用得最多的工具之一。

- 数据采集: Sqoop (关系型数据库和Hadoop之间传输数据)、Flume (采集、聚合、移动大量日志数据)。

- NoSQL数据库: HBase (构建在HDFS之上的分布式、面向列的数据库)。

- 协调服务: Zookeeper (分布式协调服务,很多组件都依赖它)。

- 高级查询: Impala/Presto (提供低延迟的SQL查询,比Hive更快)。

- 工作流调度: Oozie/Airflow (用来管理多个Hadoop任务的依赖和执行顺序)。

难点: 你需要把这些组件串起来理解,形成一个完整的“数据从哪里来 -> 存到哪里 -> 怎么处理 -> 怎么查询”的流程,孤立地学任何一个点,都很难在实际项目中应用。

-

概念高度抽象 Hadoop的设计思想是“分而治之”,很多概念都和你熟悉的单机编程完全不同。

- 分布式思想: 你需要理解什么是分布式存储、分布式计算、容错机制(副本机制)、数据本地性等,这些思想不是靠看几遍文档就能理解的,需要反复思考。

- API设计: MapReduce的编程模型(Mapper -> Reducer)对新手来说非常不直观,写一个简单的“Word Count”可能都要琢磨半天。

-

实践环境搭建复杂 这是自学者最大的“拦路虎”。

- 硬件要求: 理想情况下,你需要一个多节点的集群来体验Hadoop的分布式特性,这对个人电脑来说是奢望。

- 软件配置: 手动在Linux上安装配置Hadoop集群(包括JDK、SSH免密登录、Hadoop、Zookeeper等)非常繁琐,版本兼容性问题、环境变量问题、配置文件错误等,任何一个环节出错都可能导致整个集群无法启动,这个过程非常耗时,且容易打击学习热情。

- 虚拟机/云平台: 虽然可以用虚拟机搭建伪分布式或全分布式集群,但对电脑性能要求高,使用云平台(如阿里云、腾讯云)的ECS服务器搭建是更好的选择,但会产生少量费用,且需要一定的Linux操作基础。

-

需要扎实的Linux和Java基础

- Linux: Hadoop集群几乎都部署在Linux系统上,你需要熟练使用Linux的基本命令(

ls,cd,cp,mv,grep,vi等)、理解文件系统结构、掌握Shell脚本编程。 - Java: 虽然现在很多工具(如Hive, Pig)避免了直接写Java代码,但Hadoop的核心组件(如HDFS, MapReduce, YARN)都是用Java编写的,阅读官方文档、调试程序、理解底层原理都离不开Java基础,特别是I/O流、多线程、网络编程等。

- Linux: Hadoop集群几乎都部署在Linux系统上,你需要熟练使用Linux的基本命令(

自学Hadoop的优势在哪里?

尽管困难重重,但自学依然是一条可行的路,尤其是在当前学习资源非常丰富的时代。

-

学习资源丰富

- 书籍: 《Hadoop权威指南》是必读的经典,虽然厚,但内容非常全面。

- 视频课程: 国内外各大平台(慕课网、B站、Coursera、Udemy)都有大量优质的Hadoop入门到进阶的视频课程,可以跟着老师的节奏一步步学。

- 官方文档: 最权威、最准确的学习资料。

- 技术博客/社区: Stack Overflow、CSDN、掘金等社区可以帮你解决绝大多数遇到的问题。

-

灵活性高 你可以按照自己的节奏和兴趣点来学习,不必受限于固定的课程表和时间表,今天想深入HDFS,明天想研究Hive,完全自由。

-

成本低 相比参加昂贵的线下培训班,自学只需要购买一些书籍或付费课程,成本要低得多,利用云平台的免费试用套餐,甚至可以零成本完成环境的搭建。

如何高效地自学Hadoop?(给自学者的路线图)

如果你决定挑战,可以按照以下步骤进行,这能大大提高你的学习效率:

打好地基(1-2周)

- Linux基础: 熟练掌握常用命令,学习Shell脚本编程,这是后续一切操作的基础。

- Java基础: 重点复习Java I/O、集合框架、多线程和网络编程的基本概念,不需要成为Java专家,但要能看懂代码。

- 计算机网络: 了解TCP/IP协议、HTTP协议等基本概念。

核心理论 + 环境搭建(2-3周)

- 核心理论:

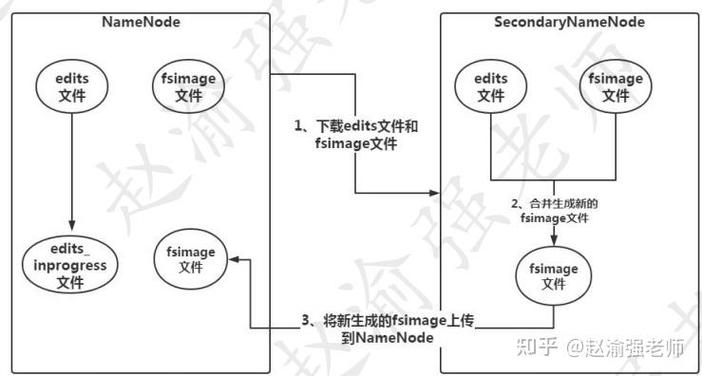

- HDFS: 深入理解其架构(NameNode, DataNode)、读写流程、副本机制(默认3副本)、数据块(Block)概念。

- MapReduce: 理解其分而治之的思想,掌握Mapper和Reducer的编程模型,能独立写出Word Count、数据去重等经典案例。

- 环境搭建:

- 强烈建议: 使用云服务器(如阿里云ECS、腾讯云CVM)购买2-3台低配机器,搭建一个真正的全分布式集群,这是最有价值的实践。

- 备选方案: 如果预算有限,可以在一台高性能电脑上用虚拟机(VMware/VirtualBox)搭建一个伪分布式或全分布式集群,或者使用Docker容器化的Hadoop镜像。

生态系统实践(4-6周)

这是将理论应用到实际的关键阶段,建议以“项目驱动”的方式进行。

- 项目设想: 模拟一个简单的用户行为分析日志系统。

- 数据采集: 学习使用Flume模拟日志数据,并采集到HDFS的指定目录。

- 数据清洗: 使用MapReduce或Hive对原始日志数据进行清洗、格式转换、过滤无效数据。

- 数据存储: 将清洗后的数据存入Hive数据仓库,并创建分区表。

- 数据分析: 使用HiveQL(类似SQL的语言)编写查询语句,进行简单的统计分析,如“每天的用户访问量Top 10”。

- 数据导出: 使用Sqoop将分析结果从Hive导出到MySQL关系型数据库中。

- (可选) 高级查询: 尝试使用Impala或Presto对同一份数据进行查询,感受其与Hive在速度上的差异。

- (可选) 实时流处理: 如果有兴趣,可以初步了解Spark Streaming或Flink,它们是Hadoop生态的下一代计算引擎,也是目前的主流。

深化与拓展(持续进行)

- 深入原理: 阅读Hadoop核心组件的源码,理解其实现细节。

- 学习Spark: Spark是当前大数据计算的事实标准,它比MapReduce快得多,且提供了统一的API(Spark Core, Spark SQL, Spark Streaming),学习Spark是Hadoop学习后的必然进阶。

- 关注云原生大数据: 学习云厂商提供的大数据服务,如AWS EMR, Azure HDInsight, 阿里云EMR等,了解如何在大数据平台上进行任务提交和管理。

总结与建议

Hadoop自学难吗? 难,但只要你方法得当、有毅力,完全可以学会。

给你的建议:

- 明确目标: 不要为了学Hadoop而学Hadoop,想清楚你学它的目的是什么?是为了转行大数据开发?还是为了做数据分析?目标不同,学习的侧重点也不同。

- 动手实践: 大数据是“练”出来的,不是“看”出来的,把理论看懂后,立刻动手敲代码、搭环境、跑任务,遇到Bug,学会利用搜索引擎和社区解决问题,这个过程本身就是宝贵的经验。

- 先广后深: 初期先快速了解整个Hadoop生态的各个组件是做什么的,形成一个整体认知,然后选择1-2个核心工具(如HDFS+Hive)进行深入学习,之后再逐步扩展。

- 拥抱云平台: 不要再纠结于在自己电脑上装虚拟机了,花一点钱租几台云服务器,你的学习效率和体验会提升一个数量级。

- 保持耐心: 学习Hadoop是一个漫长的过程,遇到挫折是正常的,坚持下去,当你成功跑通第一个完整的数据分析流程时,那种成就感是无与伦比的。

祝你学习顺利!