Python爬虫全栈学习路线图

第一阶段:基础入门 (预计1-2周)

这个阶段的目标是掌握Python爬虫所需的基础知识,搭建好开发环境。

环境准备

- 安装Python: 从官网下载并安装Python (建议3.8+版本)。

- 配置虚拟环境: 学习使用

venv或conda创建和管理项目环境,避免包冲突。 - 安装IDE/编辑器: 推荐使用 PyCharm (社区版免费)、VS Code 或 Sublime Text。

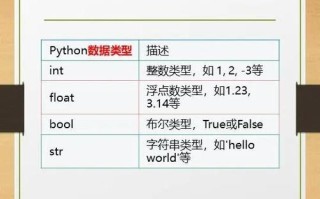

Python核心语法复习

- 变量、数据类型: 字符串、列表、元组、字典、集合。

- 流程控制:

if-else条件语句,for/while循环。 - 函数: 定义函数、参数传递、返回值。

- 模块与包:

import语句、pip包管理工具的使用。 - 文件操作:

open(),read(),write(),with语句。 - 异常处理:

try-except结构,让你的程序更健壮。

必备第三方库安装

- 在终端中使用

pip install安装以下库:requests: 发送HTTP请求的核心库。BeautifulSoup4: 解析HTML/XML的库。lxml: 高性能的HTML解析器,常与BeautifulSoup配合使用。re: Python内置的正则表达式库。

第二阶段:核心爬虫技术 (预计2-3周)

这是爬虫学习的核心,你将学习如何获取和解析网页数据。

网页请求与获取

- HTTP/HTTPS协议基础: 了解GET、POST请求方法,URL、请求头、响应头等概念。

- 使用

requests库:- 发送简单的GET请求 (

requests.get())。 - 传递URL参数 (

params参数)。 - 传递表单数据 (

data参数)。 - 设置请求头 (

headers参数),模拟浏览器访问。 - 处理响应内容 (

response.text,response.content,response.json())。 - 获取状态码 (

response.status_code)。

- 发送简单的GET请求 (

数据解析

- 解析目标: 定位到包含我们所需数据的HTML标签。

- 使用

BeautifulSoup库:- 初始化

BeautifulSoup对象。 - 核心方法:

find(): 查找第一个匹配的标签。find_all(): 查找所有匹配的标签。- CSS选择器:

select_one()和select(),这是最常用和最高效的方式。

- 提取信息:

- 获取标签文本:

tag.text或tag.get_text() - 获取标签属性:

tag['href']或tag.get('src')

- 获取标签文本:

- 初始化

- 使用

lxml库:- 介绍

xpath语法,这是一种更强大、更灵活的定位语言。 - 使用

etree模块进行解析。

- 介绍

- 使用正则表达式 (

re):- 当数据没有规律,或需要从文本中提取特定格式的字符串时使用。

- 学习常用模式:

re.match(),re.search(),re.findall()。

实战项目一:静态网页爬取

- 目标: 爬取豆瓣Top250电影电影名称、评分、一句话简介。

- 步骤:

- 分析豆瓣Top250网页结构。

- 使用

requests获取网页HTML。 - 使用

BeautifulSoup和CSS选择器解析电影信息。 - 将数据保存到文件中(如TXT、CSV)。

- 编写循环,爬取多页数据。

第三阶段:进阶技巧与反爬应对 (预计2-3周)

真实网站都有反爬虫机制,本阶段教你如何应对,让爬虫更稳定、更高效。

动态网页爬取

- 问题: 数据由JavaScript动态生成,

requests获取不到真实数据。 - 解决方案: 使用浏览器自动化工具。

- 使用

Selenium库:- 搭配浏览器驱动 (如 ChromeDriver)。

- 控制浏览器打开网页、点击、输入、滚动等操作。

- 获取动态加载后的页面源码,再用

BeautifulSoup解析。 - 元素定位:

find_element_by_id,find_element_by_xpath,find_element_by_css_selector等。

反爬虫策略与应对

- User-Agent检测:

- 应对: 创建一个User-Agent池,每次请求随机选择一个。

- IP限制 (封禁):

- 应对: 使用代理IP,学习使用免费代理IP和付费代理IP服务。

- 验证码:

- 简单图形验证码: 可能需要第三方打码平台(如超级鹰)。

- 滑动验证码: 通常需要Selenium模拟拖动。

- 点选验证码: 同样需要Selenium或AI识别。

- 登录限制:

- 应对: 维护Session,使用

requests.Session()保持登录状态。

- 应对: 维护Session,使用

数据存储

- CSV文件: 使用Python内置的

csv模块。 - Excel文件: 使用

openpyxl或xlwt库。 - JSON文件: 使用Python内置的

json模块。 - 数据库:

- SQLite: 轻量级文件数据库,适合小型项目。

- MySQL/PostgreSQL: 学习使用

pymysql或psycopg2连接关系型数据库。 - MongoDB: 学习使用

pymongo连接NoSQL数据库,适合存储非结构化数据。

实战项目二:动态网页与反爬

- 目标: 爬取某电商网站的商品信息(名称、价格、评论)。

- 步骤:

- 分析网站,确认数据是否为动态加载。

- 使用

Selenium模拟浏览器操作,获取页面源码。 - 处理可能的登录或验证码问题。

- 使用代理IP防止被封。

- 将数据结构化并存入MySQL数据库。

第四阶段:项目实战与框架应用 (预计2-4周)

将所学知识整合,完成一个更复杂的综合性项目,并学习专业的爬虫框架。

综合实战项目三:爬取全站数据

- 目标: 爬取一个新闻网站或博客网站的所有文章标题、内容和发布时间。

- 技术点:

- 使用

requests或Scrapy的URL调度器。 - 实现深度爬取,发现并爬取所有内链。

- 遵守

robots.txt协议。 - 使用

Scrapy框架(见下文)。 - 数据存储到MongoDB或Elasticsearch中。

- 使用

爬虫框架 - Scrapy

- 为什么用框架?: Scrapy提供了完整的爬虫解决方案,包括请求调度、下载、解析、数据管道等,效率远高于手写。

- 核心组件:

- Spider: 爬虫的核心,定义了如何爬取某个网站。

- Item: 定义你想要抓取的数据结构。

- Pipeline: 处理从Spider中获取的数据(如清洗、存储)。

- Downloader: 下载网页内容。

- Scheduler: 调度请求。

- 实战项目四:使用Scrapy重写之前的爬虫

- 学习使用

scrapy startproject创建项目。 - 编写Spider。

- 编写Pipeline将数据存入JSON或数据库。

- 配置

settings.py(设置User-Agent, 并发数等)。

- 学习使用

第五阶段:部署与扩展 (长期学习)

让你的爬虫从“玩具”变成“产品”。

爬虫部署

- 云服务器: 将爬虫代码部署到阿里云、腾讯云等服务器上,使其7x24小时运行。

- 进程管理: 使用

supervisor或systemd管理爬虫进程,实现开机自启和自动重启。 - 日志记录: 使用Python的

logging模块记录爬虫运行状态,方便排查问题。

分布式爬虫

- 问题: 单机爬取速度慢,IP容易被封。

- 解决方案: Scrapy-Redis框架。

- 将Scrapy的请求队列和去重集合由Redis实现。

- 多台机器可以共享同一个任务队列,协同工作。

数据可视化

- 目标: 将爬取的数据用图表展示出来。

- 工具:

- Matplotlib / Seaborn: Python基础绘图库。

- Pyecharts: 生成交互式图表,效果炫酷。

- 实战项目: 将电影评分数据绘制成柱状图、词云图等。

法律与道德

- 学习

robots.txt: 了解网站的爬取规则。 - 尊重网站: 设置合理的爬取间隔 (

DOWNLOAD_DELAY),避免对服务器造成过大压力。 - 版权意识: 明确爬取数据的用途,不要用于商业用途或侵犯他人隐私。

学习资源推荐

- 书籍:

《Python网络数据采集》: 经典入门书籍,理论结合实践。

- 网站:

- 菜鸟教程: Python基础语法速查。

- Scrapy官方文档: 学习Scrapy框架的最佳资料。

- Requests官方文档: 学习

requests库的权威指南。 - 知乎/CSDN/博客园: 搜索具体问题,有大量高质量的实战教程。

- 视频课程:

- B站: 搜索“Python爬虫”,有大量免费且优质的视频课程,如“黑马程序员”、“尚硅谷”等机构的公开课。

- 练习平台:

- 练练手: 爬取自己的博客、豆瓣、知乎等网站的数据(注意遵守规则)。

- 天池、Kaggle: 参与数据挖掘竞赛,获取真实数据集进行练习。

学习建议

- 动手实践: 爬虫是实践性极强的技能,不要只看不练,跟着教程敲代码,然后尝试修改和扩展。

- 学会分析: 爬虫的核心是分析网页,学会使用浏览器的“开发者工具”(F12)来分析网络请求和HTML结构。

- 耐心调试: 遇到问题是常态,学会阅读错误信息,善用搜索引擎,你会解决90%的问题。

- 逐步深入: 不要急于求成,先掌握静态网页,再挑战动态网页,最后再学习框架和分布式。

祝你学习顺利,早日成为爬虫高手!

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。