太棒了!自学 Hadoop 是一个非常有价值且充满挑战的决定,Hadoop 生态系统庞大,但只要遵循一条清晰的学习路径,完全可以掌握。

这是一份为你量身定制的、从零到一的 Hadoop 自学路线图,涵盖了理论、实践、工具和进阶方向。

第一阶段:心态与基础准备 (1-2周)

在开始之前,你需要做好充分的准备,这会让你事半功倍。

心态调整

- 耐心与毅力: Hadoop 概念抽象,配置复杂,遇到问题是常态,不要指望一蹴而就,享受解决问题的过程。

- 实践为王: Hadoop 是实践性极强的技术,看再多视频、读再多书,不亲手操作都是空谈。必须搭建自己的实验环境!

- 系统性思维: Hadoop 解决的是大数据存储和计算问题,要理解其分布式设计的思想,而不仅仅是学会几个命令。

基础知识储备

这是学习 Hadoop 的基石,如果基础不牢,后续会非常痛苦。

-

核心基础:

- Linux 基础: 这是最重要的前提! 你必须熟练掌握 Linux 常用命令(

ls,cd,cp,mv,rm,mkdir,grep,find,chmod,chown等)、Shell 脚本编写基础、软件安装方式(yum,tar.gz),Hadoop 集群几乎都运行在 Linux 系统上。 - Java 基础: Hadoop 本身就是用 Java 编写的,你需要掌握 Java SE 的核心知识,特别是 Java I/O、多线程、网络编程,不一定要成为 Java 大神,但必须能看懂 Hadoop 源码中的简单逻辑,并具备基本的 Java 编程能力。JDK 8 是目前最稳定和广泛使用的版本。

- Linux 基础: 这是最重要的前提! 你必须熟练掌握 Linux 常用命令(

-

加分项:

- 计算机网络: 了解 TCP/IP、HTTP、DNS 等基本概念,有助于理解 Hadoop 各个组件之间的通信。

- 数据结构与算法: 了解 MapReduce 的基本原理,数据结构知识会让你理解得更快。

- SQL 基础: Hive 是 Hadoop 上的数据仓库,其查询语言类似 SQL,有 SQL 基础会更容易上手。

第二阶段:核心理论与入门实践 (4-6周)

这是学习 Hadoop 的核心阶段,目标是理解其核心组件并完成第一次“Hello World”。

Hadoop 核心理论

- 学习目标: 理解 Hadoop 是什么,解决了什么问题,以及其核心组件的工作原理。

- 核心概念:

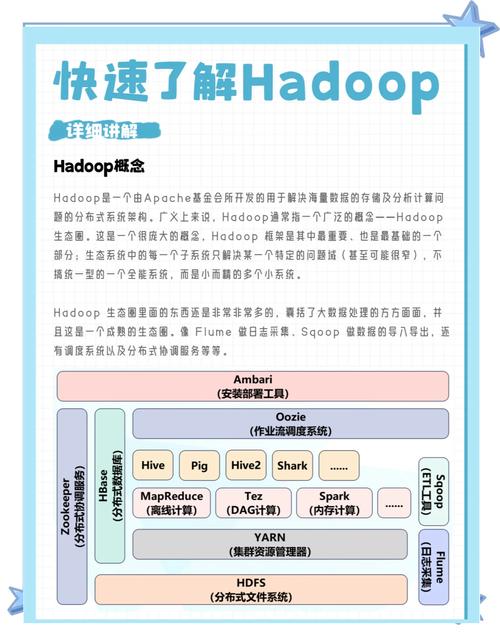

- Hadoop 生态系统: 了解 Hadoop 不是一个单一软件,而是一个生态系统,主要包括:

- HDFS (Hadoop Distributed File System): 分布式文件系统,理解其 NameNode (元数据管理) 和 DataNode (数据存储) 的架构、数据块(Block)副本机制。

- MapReduce: 分布式计算框架,理解其 分而治之 的思想,掌握 Map (映射) 和 Reduce (规约) 两个阶段的执行流程。

- YARN (Yet Another Resource Negotiator): 资源管理器,理解它如何管理集群资源(CPU、内存)和调度任务。

- Hadoop 版本: 了解 Hadoop 2.x 和 3.x 的主要区别。Hadoop 3.x 是主流,但很多企业仍在使用 2.x,可以先从 2.x 入手,再了解 3.x 的新特性(如 HDFS Erasure Coding)。

- Hadoop 生态系统: 了解 Hadoop 不是一个单一软件,而是一个生态系统,主要包括:

搭建实验环境

- 强烈建议:不要用 Windows! Hadoop 的原生环境就是 Linux。

- 环境选择(三选一,按推荐度排序):

- 虚拟机 + Linux (强烈推荐):

- 工具: VMware Workstation / VirtualBox。

- 系统: CentOS 7 / Ubuntu Server,选择一个你熟悉或更稳定的版本。

- 配置: 至少准备 3 台虚拟机(1个 Master 节点,2个 Slave 节点),每台虚拟机配置 2GB 以上内存和 20GB 以上硬盘。

- 优点: 最贴近生产环境,能让你完整体验集群搭建、配置、网络互通等所有环节,收获最大。

- 云服务器:

- 平台: 阿里云、腾讯云、AWS 等。

- 配置: 购买 3 台轻量应用服务器或 ECS 实例。

- 优点: 无需自己维护虚拟机,网络环境稳定,可以随时随地访问。

- 缺点: 可能需要付费。

- 伪分布式模式:

- 概念: 在一台 Linux 机器上,用不同的进程模拟 Master 和 Slave 节点。

- 优点: 配置简单,对机器配置要求低,适合快速验证概念和入门。

- 缺点: 无法体验真正的分布式环境,不适合深入学习集群管理。

- 虚拟机 + Linux (强烈推荐):

入门实践

- 目标: 成功安装并启动 Hadoop 集群,运行第一个官方示例程序。

- 实践步骤:

- 环境配置: 在所有节点上配置

hostname、hosts文件、SSH 免密登录、JDK、Hadoop 环境变量等。 - 集群部署: 解压 Hadoop,配置

core-site.xml,hdfs-site.xml,yarn-site.xml,workers等核心配置文件。 - 格式化与启动: 格式化 HDFS 文件系统,然后启动 HDFS 和 YARN 服务。

- 验证: 使用

jps命令检查每个节点上的进程是否正常启动。 - 运行 WordCount: 上传一个文本文件到 HDFS,然后运行

hadoop jar命令执行 WordCount 程序,最后下载结果文件查看。这是你的第一个里程碑!

- 环境配置: 在所有节点上配置

第三阶段:深入核心组件与生态工具 (2-3个月)

掌握了基础后,需要深入各个组件,并学习周边生态工具,这是从“会用”到“理解”的关键。

HDFS 深入

- 读写流程: 深入理解一个文件是如何被写入和读取的,包括客户端、NameNode、DataNode 之间的交互。

- NameNode 高可用: 学习 HDFS 2.x 的 HA 方案,基于 QJM (Quorum Journal Manager) 或 ZKFC。

- Federation (联邦): 了解如何通过 Federation 来突破单个 NameNode 的内存瓶颈。

- 运维命令: 熟练使用

hdfs dfs命令进行文件操作,学习hdfs dfsadmin、hfsfsck等管理命令。

MapReduce 深入

- API 编程: 尝试自己用 Java 编写 MapReduce 程序,处理一些复杂场景(如数据连接、自定义分区、Combiner 等)。

- 工作原理: 理解 InputFormat、Mapper、Partitioner、Reducer、OutputFormat 等组件的作用。

- YARN 深入: 理解 YARN 的两大核心组件:ResourceManager (RM) 和 NodeManager (NM),以及 ApplicationMaster (AM) 的生命周期。

- 调度器: 了解 Capacity Scheduler 和 Fair Scheduler 的基本概念。

核心生态工具学习

Hadoop 的价值在于其丰富的生态,以下是你必须掌握的工具:

- Hive: 数据仓库工具。

- 学习重点: HiveQL (类 SQL 语法)、Hive 的数据模型(表、分区、分桶)、Metastore (元数据存储)、Hive 的执行引擎(MapReduce/Tez/Spark)。

- HBase: 分布式 NoSQL 数据库。

- 学习重点: 理解其面向列的存储模型、RegionServer 和 HMaster 的架构、RowKey 的设计、HBase 与 MapReduce/Spark 的集成。

- Sqoop: 数据迁移工具。

- 学习重点: 学习如何将关系型数据库(如 MySQL)的数据导入 HDFS,以及将 HDFS 的数据导出到关系型数据库。

- Flume: 日志采集工具。

- 学习重点: 理解其 Source-Channel-Sink 的三层架构,并能配置简单的数据采集任务。

- ZooKeeper: 分布式协调服务。

- 学习重点: 了解其数据模型(Znode)、Watcher 机制,以及它在 Hadoop、HBase、Kafka 等组件中扮演的角色(如实现 HA、选举 Leader)。

第四阶段:进阶与实战 (持续学习)

当你掌握了以上内容后,就可以开始向更高级、更贴近生产的方向发展。

计算引擎升级

- Spark: 这是现代大数据的必备技能! Spark 因其内存计算和 DAG 执行引擎,已经逐渐取代 MapReduce 成为主流计算框架。

- 学习路径: 先学习 Scala (Spark 的原生语言) 或 Python (PySpark),然后掌握 Spark Core、Spark SQL、Spark Streaming、MLlib (机器学习) 和 GraphX。

- 理解 Spark on YARN: 学习 Spark 如何在 YARN 上运行资源。

- Flink: 另一个强大的流处理引擎,以其真正的流处理能力和低延迟著称,如果你对实时计算感兴趣,Flink 是必学的。

资源调度与管理

- Kubernetes (K8s): 容器化编排平台正在成为大数据平台的新标准,学习如何使用 K8s 来部署和管理 Hadoop、Spark 等组件,了解 K8s 与 YARN 的对比和融合趋势。

云原生大数据

- 学习重点: 了解云厂商提供的大数据服务,如 AWS EMR, Azure HDInsight, 阿里云 E-MapReduce 等,理解其架构和如何使用它们来快速搭建和运维大数据集群。

实战项目

- 寻找真实数据集: 在 Kaggle、UCI 等网站找一些公开的大数据集。

- 构建一个完整的数据处理流水线:

- 使用 Flume 采集服务器日志到 HDFS。

- 使用 Sqoop 将业务数据库的数据导入 Hive/HBase。

- 使用 Spark/Hive 对数据进行清洗、转换和分析。

- 将分析结果存入 MySQL 或直接用 BI 工具(如 Superset, Metabase)进行可视化展示。

推荐学习资源

书籍

- 入门圣经:《Hadoop 权威指南》 (第4版对应 Hadoop 3),这本书非常全面,适合系统性地学习。

- 理论经典:《大数据技术原理与应用》 (林子雨),这本书概念清晰,适合初学者建立知识框架。

在线课程

- 国内: 慕课网、CSDN 学院、B站上有很多优质的 Hadoop 教程,搜索“Hadoop入门”、“Hadoop集群搭建”等关键词。

- 国外: Coursera, Udemy, edX 上有大量英文课程,质量普遍很高。

实践环境

- Cloudera QuickStart VMs: 一键安装的虚拟机,预装了 CDH (Cloudera's Distribution including Hadoop),非常方便快速体验。

- Docker: 可以使用 Docker Compose 快速搭建一个 Hadoop 集群,适合开发者快速测试。

社区与文档

- 官方文档: Apache Hadoop 官方文档 是最权威、最准确的资料,遇到问题首先要查阅官方文档。

- 技术博客: 关注一些大数据技术专家的博客(如美团、阿里、腾讯的技术团队分享)。

- Stack Overflow: 解决编程问题的最佳去处。

自学 Hadoop 的旅程可以概括为:

打好基础 (Linux, Java) -> 理论先行 (HDFS, MapReduce, YARN) -> 动手实践 (搭建集群, 运行程序) -> 深入生态 (Hive, HBase, Sqoop...) -> 进阶升级 (Spark, K8s, 云原生) -> 项目实战。

这条路虽然漫长,但只要你坚持下去,一步一个脚印,最终一定能成为一名合格的大数据工程师,祝你学习顺利!

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。