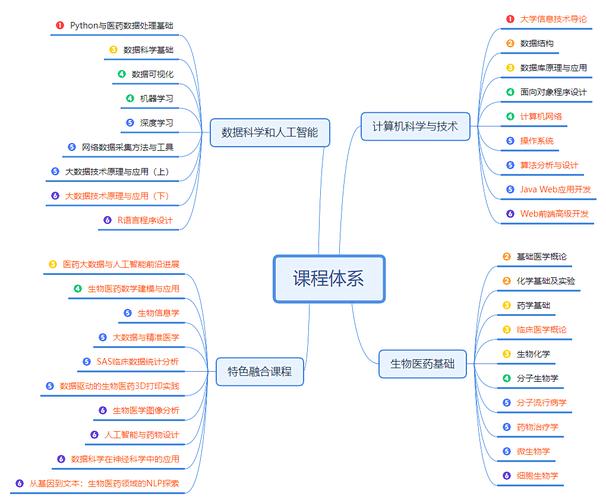

数据科学与大数据技术专业课程体系总览

这个专业的核心目标是培养具备数学统计基础、计算机技术能力、业务领域知识的复合型人才,学生需要学会如何从海量、复杂的数据中提取有价值的信息,并用这些信息来解决实际问题。

课程体系通常可以分为四大模块:

- 数学与统计基础:数据科学的“内功”,理解数据背后的规律。

- 计算机科学与技术:处理大数据的“工具箱”,实现算法和模型。

- 数据科学与核心技能:连接理论与实践的“桥梁”,核心方法论。

- 大数据技术平台:应对海量数据的“引擎”,分布式处理框架。

- 领域应用与实践:将知识转化为价值的“战场”,解决实际问题。

数学与统计基础

这是数据科学的基石,决定了你未来能走多远,尤其是在模型理解和创新方面。

-

高等数学 / 微积分

- :极限、导数、积分、级数。

- 为何重要:理解优化算法(如梯度下降)的基础,很多机器学习模型的损失函数最小化过程都依赖于微积分。

-

线性代数

- :矩阵、向量、行列式、特征值与特征向量、奇异值分解。

- 为何重要:数据在计算机中通常以矩阵形式存在,降维算法(PCA)、推荐系统、深度学习等都离不开线性代数。

-

概率论与数理统计

- :概率分布、期望、方差、假设检验、置信区间、回归分析。

- 为何重要:这是数据科学的“语言”,它帮助我们理解数据的不确定性,进行有效的推断,并评估模型的性能。

-

离散数学

- :集合论、图论、逻辑、组合数学。

- 为何重要:为算法设计、数据结构、网络分析等提供理论基础。

计算机科学与技术

这是实现数据科学想法的“硬实力”。

-

程序设计基础

- 核心语言:Python (首选)、R、SQL。

- Python重点:语法、数据结构、函数、面向对象编程。

- 为何重要:Python拥有最丰富的数据科学生态库,是事实上的行业标准。

-

数据结构与算法

- :数组、链表、栈、队列、树、图、哈希表;排序、查找、动态规划等。

- 为何重要:编写高效代码的基础,在处理大规模数据时,算法的优劣直接影响性能。

-

数据库系统原理

- :关系型数据库、SQL语言、数据库设计、事务、索引。

- 为何重要:数据存储和管理的基石,80%的数据科学工作时间可能都花在数据清洗和准备上,这离不开数据库操作。

-

操作系统与计算机网络

- :进程管理、内存管理、文件系统;TCP/IP协议、HTTP协议。

- 为何重要:理解分布式计算框架(如Hadoop、Spark)运行的基础环境。

数据科学与核心技能

这是将数学和计算机知识融合,解决实际问题的核心方法论。

-

数据科学导论

- :数据科学生命周期、CRISP-DM模型、数据科学家的角色与职责。

- 为何重要:建立对整个领域的宏观认识。

-

数据获取与预处理

- :网络爬虫、API调用、数据清洗(处理缺失值、异常值)、数据集成、数据变换(标准化、归一化)。

- 为何重要:“Garbage in, garbage out.” 这是数据科学项目中耗时最长但至关重要的一步。

-

探索性数据分析

- :描述性统计、数据可视化(使用Matplotlib, Seaborn, Plotly等)。

- 为何重要:在建模之前,通过可视化和统计手段理解数据分布、发现规律和异常。

-

机器学习

- :

- 监督学习:线性回归、逻辑回归、决策树、支持向量机、K近邻、朴素贝叶斯。

- 非监督学习:聚类算法、降维算法。

- 模型评估与调优:交叉验证、混淆矩阵、ROC曲线、超参数调优。

- 为何重要:从数据中学习并做出预测的核心技术。

- :

-

深度学习

- :神经网络、反向传播、卷积神经网络、循环神经网络、Transformer。

- 为何重要:在图像识别、自然语言处理等复杂任务上取得了突破性进展。

-

自然语言处理

- :文本预处理、词向量、情感分析、文本分类、机器翻译。

- 为何重要:让机器理解和生成人类语言。

-

数据可视化

- :可视化原则、交互式可视化仪表盘(使用Tableau, Power BI, Dash等)。

- 为何重要:将分析结果以直观、有说服力的方式呈现给决策者。

大数据技术平台

专门用于处理“无法在单台机器上处理”的海量数据。

-

大数据导论

- :大数据的4V特征(Volume, Velocity, Variety, Value)、生态系统概述。

-

Hadoop生态系统

- :

- HDFS (Hadoop Distributed File System):分布式存储。

- MapReduce:分布式计算模型。

- Hive:数据仓库工具,提供类SQL查询。

- HBase:NoSQL数据库,用于实时读写随机访问。

- :

-

Spark核心

- :Spark架构、RDD (弹性分布式数据集)、Spark SQL、Spark Streaming、MLlib (机器学习库)。

- 为何重要:比MapReduce更快、更通用的大数据处理引擎,已成为行业标准。

-

实时计算与流处理

- :流处理概念、Spark Streaming、Flink。

- 为何重要:处理实时数据流,如用户行为日志、金融交易等。

-

NoSQL数据库

- :文档型、键值型、列族型、图数据库的原理与应用场景。

领域应用与实践

将所学知识应用到具体场景中,并完成综合项目。

-

推荐系统

- :协同过滤、基于内容的推荐、混合推荐。

-

金融科技

- :信用评分、反欺诈、量化交易。

-

人工智能伦理与治理

- :算法偏见、数据隐私、模型可解释性、公平性。

- 为何重要:确保技术向善,负责任地使用数据。

-

毕业设计/综合项目

- 要求:独立或小组合作,从数据获取、清洗、分析、建模到部署,完成一个端到端的数据科学项目,并撰写报告和进行答辩。

学习路径建议

-

第一阶段(打基础 - 约6-12个月):

- 主攻 Python 和 数学/统计基础。

- 学习 SQL 和 数据结构与算法。

- 完成 Kaggle 上的入门竞赛和 Titanic 等经典项目。

-

第二阶段(核心技能 - 约6-12个月):

- 系统学习 机器学习 理论,并使用 Scikit-learn 实践。

- 深入 数据可视化 和 EDA。

- 探索 NLP 或 深度学习 的一个方向。

- 开始学习 Hadoop/Spark 的基本使用。

-

第三阶段(深化与专精 - 长期):

- 选择一个感兴趣的方向(如NLP、计算机视觉、推荐系统)深入学习。

- 学习 大数据框架 的底层原理和调优。

- 构建一个复杂的、有影响力的个人项目,并展示在GitHub上。

- 学习 云平台(如AWS, Azure, GCP)上的数据服务。

推荐资源

- 在线课程:Coursera (吴恩达的机器学习/深度学习专项)、edX、Udacity。

- 书籍:《Python for Data Analysis》、《Hands-On Machine Learning with Scikit-Learn, Keras & TensorFlow》、《统计学习方法》(李航)。

- 竞赛平台:Kaggle、天池。

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。